参考了博客,但是这篇博客提供命令我也执行不了。如果你也成功不了,可以试试我的步骤。

网上有很多博客介绍如何使用开源工具wiki extractor解压提取维基百科上的数据,但是我试了一下他们的命令发现没一个能用的,而且他们对于该命令基本都是一笔带过,没有做深入的解释,对于我这种小白在第一步就卡死了。另外他们大部分人都是用linux系统,还有些使用Mac系统,用Windows的只有少数,而且他们提供的命令还不好用。所以我在此提供Windows系统的使用办法。

- 数据来源:维基百科数据

- 首先进入wiki extractor的官网。发现里面有很多py文件,与其他人写的博客上的教程完全不一样。别人的教程只有一个WikiExtractor.py文件。

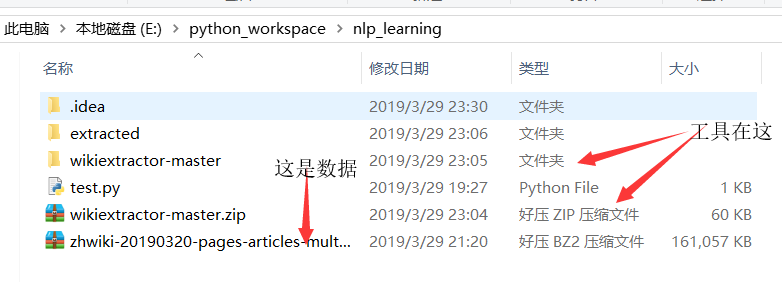

- 将该项目clone下来,放在你的项目中。如下图:

我下的是压缩包,解压开后就存放在wikiextractor-master文件夹。至于test.py只是用来测试gensim的word2vec算法好不好用的,无视就好。

我下的是压缩包,解压开后就存放在wikiextractor-master文件夹。至于test.py只是用来测试gensim的word2vec算法好不好用的,无视就好。 - 进入wikiextractor-master文件夹执行

python setup.py install,该步骤用于安装wiki extractor。其实wiki extractor的官网也写了这一步。但是不知道为什么其他人的博客没人介绍。 - 退出该文件夹到nlp_learning文件夹,执行

python wikiextractor-master/WikiExtractor.py -b 1200M -o extracted zhwiki-20190320-pages-articles-multistream1.xml-p1p162886.bz2,这个命令应该很好理解,说一下里面的extracted,它是目标文件夹,就是提取出来的文本存放的那个文件夹。可以看到上面的图片里有这个文件夹。-b代表每多大字节输出一份文件,参数的具体使用方法可以到这里查询。 - 接下慢慢等就行了,我的文件157MB,大概洗脸刷牙后就提取完了。