本文的公式不存在次方的说法,所以看见上标,不要想成是次方。 对于权重的表示问题,请看博客,但是由于是以前的学习笔记,不保证完全正确。 如果想了解为什么梯度下降要对w和b求导,可以看这篇。 建议边看边写,否则思维跟不上。

前言

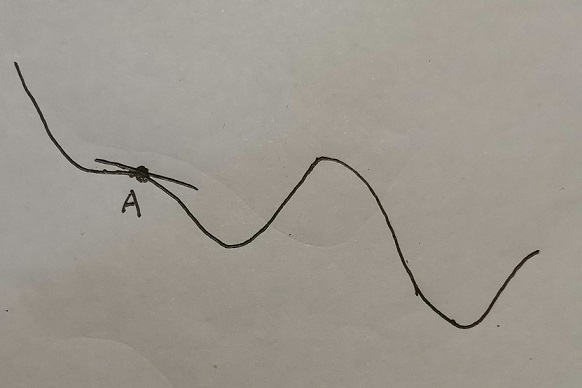

参考文章 以如下神经网络架构为例。参考文章中使用了一个2 2 2的神经网络架构,但是现实中神经网络架构不会这么整整齐齐。所以还是使用了略复杂的架构,此外原文中未对bias(偏差)更新。另外原文也没有实现向量化后的计算。虽然在后面的代码写了,但是由于代码太长了,有一种代码我给出来了,你们自己去看的感觉。说实话没多少注释,都没看的欲望(╬ ̄皿 ̄)。然后她所使用的符号让我不太习惯,因为看吴恩达以及李宏毅老师使用的符号都是\(w^l_{ji}\ a^l_i\)等等,所以自己重新推导一遍,并且使用了数学公式,而不是截图,更好看一点。 解释一下最下面的神经元,这个神经元初始化为1,也就是意味着1 * b = b。输入值为1,一个偏差乘1还是偏差本身。